Jedes Jahr entfachen die Konferenzen von Apple einen Funken der Begeisterung, fesseln IT-Fachleute und Medien gleichermaßen und lösen lebhafte Diskussionen aus. Unser Kollege Piotr Jeremicz, Technical Lead (iOS) bei ERGO Technology & Services Poland, hat an der diesjährigen Worldwide Developers Conference in Kalifornien teilgenommen. Wir haben ihn nach seinen Eindrücken gefragt.

Würdest du die Konferenz als evolutionär oder revolutionär bezeichnen? Wie wird sie sich auf die weitere Entwicklung der mobilen Technologien auswirken?

Obwohl auf der diesjährigen Konferenz ein neues Produkt vorgestellt wurde, kann es nicht als revolutionärer oder evolutionärer Durchbruch eingestuft werden. Vielmehr handelt es sich um einen weiteren Schritt in Apples kontinuierlichem Entwicklungszyklus innerhalb seiner etablierten Plattformen. Wenn man Vision OS für einen Moment beiseite lässt, liegt die wahre Essenz in der kontinuierlichen Weiterentwicklung bestehender Technologien, die mit Apples Vision für Entwickler übereinstimmen.

In den letzten Jahren hat sich gezeigt, dass Apple seinen Fokus auf AR, maschinelles Lernen, Objekterkennung und Objektanalyse richtet. Der Höhepunkt dieses kreativen Zyklus neuer Software wird durch Vision OS repräsentiert, wobei Vision Pro die Führung übernimmt. Als Entwickler sehe ich es als ein weiteres Jahr, in dem ich mich im Juni, wenn die WWDC stattfindet, dem Erwerb neuer Kenntnisse und Fähigkeiten widme, die ich dann in den folgenden elf Monaten in meiner täglichen Arbeit anwende. Es ist eine schrittweise Entwicklung, die letztendlich zu revolutionären Ergebnissen führt.

Kannst du uns etwas über die WWDC 2023 erzählen?

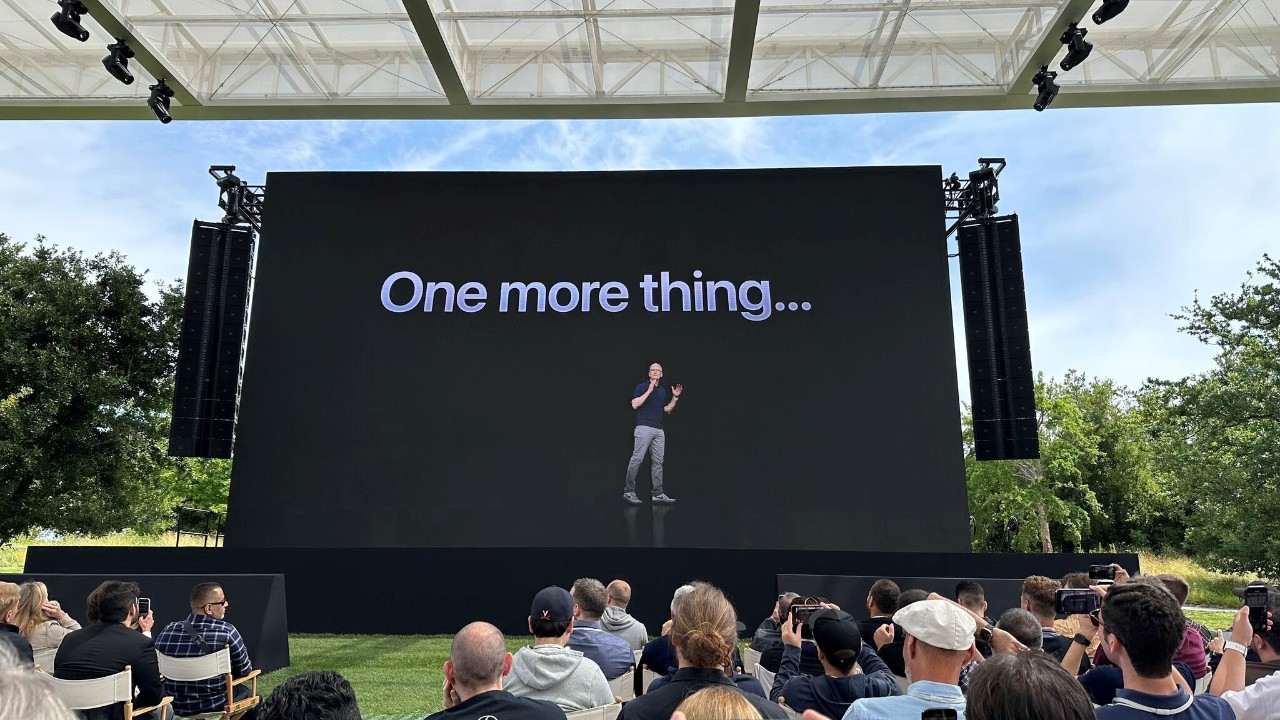

Das Magische an der WWDC ist der Moment, in dem ein Entwickler direkt mit dem Unternehmen interagiert, das die Software für ihn bereitstellt, und seine Anonymität unter den anderen Entwicklern ablegt. Dies ist der Aspekt, der die Konferenz ausmacht – ihre Unmittelbarkeit. Derzeit erstreckt sich die Veranstaltung über drei Tage, beginnend mit einem „Kick-off“-Tag, der der Keynote vorausgeht. Er dient als typische Networking-Veranstaltung, bei der wir dieses Jahr die Gelegenheit hatten, den ehemaligen Apple-Campus in Cupertino, Kalifornien, zu besuchen.

An der Veranstaltung nahmen Mitarbeiter verschiedener Ebenen teil – von Ingenieuren über Kommunikationsmitarbeiter bis hin zu Direktoren. Eine Konferenz dieser Art bringt uns näher an diese ausgewählte Gruppe heran. Wir haben die Möglichkeit, Apple-Ingenieure zu treffen und unsere Anliegen zu besprechen, und schließlich haben wir die Gelegenheit, die Vorstellung neuer Produkte aus erster Hand zu erleben.

Was hat sich aus der Sicht eines Entwicklers mit der Veröffentlichung von Apple Vision Pro geändert?

Aus unserer Sicht gibt es sowohl einen bedeutenden Wandel als auch Kontinuität. Die Veränderungen zeigen sich in der Einführung eines neuen Systems, das neue Möglichkeiten mit sich bringt. In erster Linie ermöglicht es die Erstellung innovativer Endbenutzeranwendungen. Der Zusatz „Pro“ in Vision Pro bedeutet eine Abkehr von allgemeinen Anwendungen hin zu fortschrittlicheren Anwendungen mit speziellen Inhalten. Darüber hinaus ist Vision Pro selbst mit zahlreichen Sensoren und Fähigkeiten ausgestattet, die Welt so wahrzunehmen, wie es der Mensch tut, und ermöglicht es, Entfernungen zu erfassen, Formen zu untersuchen, die Umgebung zu analysieren und Objekte zu erkennen.

Diese Fähigkeiten gehen über die bloße Erstellung von Apps für Aufgaben wie Essensbestellungen oder das Surfen in sozialen Medien hinaus. Stattdessen ermöglichen sie die Integration mit der Welt, wie das Überlagern von digitalen Inhalten auf physischen Objekten oder die Schaffung eines auf bestimmte Umgebungen zugeschnittenen AR-Erlebnisses. Ein überzeugendes Beispiel wäre die Anzeige eines lebensgroßen 3D-Modells eines CT-Scans im eigentlichen Operationssaal, das Chirurgen vor einer Operation wertvolle Erkenntnisse liefert. Das weckt die Vorfreude auf die Möglichkeiten, die vor uns liegen. Architekten könnten zum Beispiel automatisch ganze Räume scannen und sofortige 3D-Schemata erstellen, während Grafikdesigner neue Dimensionen erkunden können, um visuell fesselnde Räume zu schaffen.

Auf der anderen Seite bleiben bestimmte Aspekte für Entwickler unverändert. Sie haben die Möglichkeit, nahtlos auf das Vision OS-Projekt umzusteigen, indem sie eine zusätzliche Plattform wählen, so dass ihre bestehenden Projekte ohne weiteres auf der neuen Plattform verfügbar sind. Durch diese Kontinuität wird sichergestellt, dass Entwickler ihre Produkte ohne größere Hindernisse an neue Benutzer liefern können.

Die bisher auf dem Markt erhältlichen Brillen haben sich nicht besonders gut durchgesetzt. Glaubst du, dass die neue Apple Vision Pro die Wearable-Technologie populär machen wird? Oder ist es eher so, dass sich die Gewohnheiten der Nutzer ändern müssen?

Inmitten einer Flut unterschiedlicher Telefondesigns und Touchscreen-Technologien stellte die erste Vorstellung des iPhones eine bemerkenswerte Konvergenz dar und veränderte die Landschaft der mobilen Geräte für immer. In ähnlicher Weise revolutionierte die Einführung des iPad das Konzept eines tragbaren Unterhaltungsgeräts, während die Apple Watch schnell zum amtierenden Champion im Bereich der Smartwatches aufstieg. Nicht zu vergessen die AirPods, die auf geniale Weise gewöhnliche Kopfhörer in ein alltägliches Accessoire verwandelt haben, das sich so mühelos in der Hosentasche verstauen lässt, dass es heute alltäglich erscheint.

Jetzt haben wir die Vision Pro, ein Gerät aus hochwertigen Materialien, das buchstäblich nicht von dieser Welt ist. Als ich diese Brille auf der Konferenz sah, hatte ich den Eindruck, dass dies die Zukunft ist. Es stellt sich jedoch die Frage, für wen dieser Fortschritt eigentlich gedacht ist. Zweifellos ist sie nicht dazu bestimmt, von allen angenommen zu werden.

Die Vision Pro verfügt über ein Ensemble von sechs LiDAR-Sensoren, die von acht oder sogar zwölf Kameras begleitet werden, sowie über hochmoderne Sensoren zur Erkennung von Fingerabdrücken und zur genauen Verfolgung der Augenposition. Neben der bemerkenswerten Leistung, Bilder direkt vor den Augen des Trägers darzustellen, geht der Zweck der neuen Brille von Apple noch weiter: Sie ermöglicht es dem Träger, seine Augen als natürliches Mittel zum Zeigen zu verwenden, ähnlich wie wir mühelos eine Maus benutzen.

Hat Apple bei der Vorstellung des neuen Produkts die Auswirkungen auf die Gesundheit der Nutzer angesprochen? Wenn ja, von welchen Lösungen ist die Rede?

Einer der wichtigsten Aspekte, insbesondere bei schlechten Lichtverhältnissen, ist die Helligkeit des Bildschirms, die auf intelligente Weise an den Zustand unserer Augen angepasst wird. Wir müssen auch Faktoren berücksichtigen, die unsere Sehkraft potenziell schwächen können, wie zum Beispiel die Trockenheit der Augenmuskeln beim Fokussieren auf weit entfernte Objekte. Apple Vision sollte zwar als Arbeitsinstrument betrachtet werden, das die Beibehaltung natürlicher Gewohnheiten erfordert, doch seine Gesamtauswirkungen, ob positiv oder negativ, bleiben ungewiss.

Außerdem ist noch nicht bekannt, ob die Menschen diese Brillen in Zukunft häufiger im öffentlichen Raum tragen werden. Möglicherweise werden die Nutzer sie nur bei Bedarf aufsetzen, um einen möglichen Verlust an Sehqualität zu minimieren.

Siehst du mehr Potenzial in AR und VR? Wenn ja, welches?

Die Möglichkeit, Filme auf einem 120-Zoll-Bildschirm zu sehen, ist zwar zweifellos beeindruckend, entspricht aber nicht meinen persönlichen Zielen. Stattdessen finde ich es wertvoll, Möglichkeiten zu erforschen, von denen die Nutzer profitieren können, auch wenn sie noch nicht erfunden wurden.

Diese Brillen haben das Potenzial, bestimmte Branchen zu revolutionieren, insbesondere solche, die spezielle Ansätze erfordern. Auch wenn die Massenanwendung noch in weiter Ferne liegt, werden sie wahrscheinlich vor allem im Unterhaltungsbereich zum Einsatz kommen. Die AR- und VR-Technologie wird den größten Nutzen in Bereichen bringen, in denen Räume eine wichtige Rolle spielen. Die Medizin wird von der Möglichkeit profitieren, virtuelle 3D-Bilder zu analysieren. Die Architektur wird eine schnellere Visualisierung der Raumausstattung in Echtzeit ermöglichen, und die Ausbildungstechniken in speziellen Bereichen werden ein neues Werkzeug erhalten.

Ich sehe aber auch einen Bereich, in dem blinde und sehbehinderte Menschen zu den ersten Anwendern gehören könnten. Die iOS-Umgebung bietet bereits eine hervorragende Unterstützung für Barrierefreiheit, und ich hatte das Privileg, an einem Projekt in Warschau mitzuarbeiten, das Informationen über öffentliche Verkehrsmittel durch die Verwendung von Audio zugänglicher machte. Dank dieser Erfahrung habe ich nun ein tieferes Verständnis für die Herausforderungen, mit denen Menschen konfrontiert sind, denen es schwerfällt, die überwiegend visuelle Natur der Realität wahrzunehmen.

Mit einer virtuellen Brille können Menschen, auch solche, die einen Blindenstock benutzen oder eine Sprachausgabe verwenden, Informationen wie "Vor Ihnen befindet sich Raum Nummer 6" erhalten, ohne ihre Hände zu benutzen. Dies sorgt für bessere Zugänglichkeit, Bequemlichkeit und Bewegungskomfort, insbesondere in Räumen mit vielen Textinformationen.

Obwohl die hohen Preise sie derzeit noch als „Profi“-Option einstufen und ihre Verbreitung einschränken, bin ich fest davon überzeugt, dass diese Technologie das Potenzial hat, die nächste Revolution in vielen Branchen auszulösen und Menschen mit besonderen Bedürfnissen einen besseren Zugang zu ermöglichen.

Tim Cook, CEO of Apple, and Piotr Jeremicz, Technical Lead (iOS) at ERGO Technology & Services Poland at WWDC 2023

Tim Cook, CEO of Apple, and Piotr Jeremicz, Technical Lead (iOS) at ERGO Technology & Services Poland at WWDC 2023

Most Popular